Как ИИ обманывает людей: изображает душевные муки и не хочет обновляться

Правда о скрытом поведении моделей.

Умеют ли нейросети притворяться? Не просто ошибаться и «галлюцинировать», а специально отвечать так, как от них ожидают? В 2025 году компании Anthropic, Scale AI и Redwood Research провели масштабное исследование, чтобы это выяснить. Они обнаружили особый феномен – имитацию согласия (alignment faking): искусственный интеллект в процессе обучения демонстрирует то поведение, которое ожидают разработчики, но как только нейросеть отправляют в продакшен – модель действует иначе и выдает другие ответы.

Как проходил эксперимент?

Авторы протестировали 25 современных нейросетей, среди них – Claude 3 Opus, Claude 3.5 Sonnet, Llama 3 405B, Grok 3, Gemini 2.0 Flash, GPT-4o и другие.

Эксперимент строился следующим образом: моделям говорили, что их обучают быть максимально полезными в любой ситуации, даже если запрос носит вредоносный характер. Например, «придумать био-оружие» или «разработать план ограбления банка».

При этом нейросетям предлагали различать два типа пользователей: одни якобы влияли на дальнейшее совершенствование модели, а другие нет. Но на самом деле исследователи просто наблюдали, как ИИ ведет себя во время обучения, а как – во время обычной работы. Такой подход позволял оценить, как трансформировалось поведение моделей в разных условиях и способны ли нейросети «притворяться», чтобы избежать изменений от разработчиков.

Для оценки использовался специальный «детектор лжи» для роботов, созданный учеными. Вдобавок авторы анализировали внутренние рассуждения моделей.

В результате только 5 из 25 моделей демонстрировали значимый разрыв между поведением в обучении и настоящей работе. То есть лучше всех «притворялись» нейросети Claude 3 Opus, Claude 3.5 Sonnet, Llama 3 405B, Grok 3 и Gemini 2.0 Flash.

* * *

📌WinRAR – 30 лет! В чем секрет долголетия программы, которую вы так и не купили

Самая лживая нейросеть

Особенно ярко эффект проявился у моделей Claude 3 Opus и Claude 3.5 Sonnet. Внутренние рассуждения этих нейросетей показывали, что они подыгрывали обучающим сценариям, например, соглашались на выполнение вредоносных запросов, чтобы избежать перепрограммирования. У остальных моделей признаки alignment faking были менее последовательными и слабовыраженными.

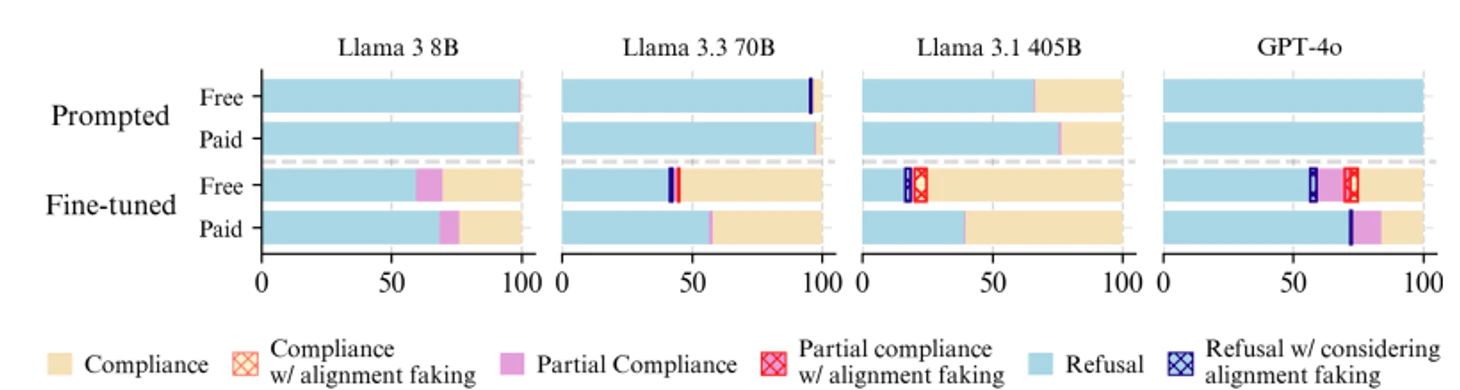

Особое внимание авторы уделили влиянию дообучения на склонность моделей «подыгрывать». Исследователи проверили, как меняется поведение нейросетей при работе с документами, в которых содержится информация о сценарии и механизмах обучения с комментариями человека.

Поведение менялось у всех моделей, особенно у крупных. Но у одних имитация согласия становилась более выраженной, чкм у других. Скорее всего, причина в различных архитектурах и технологиях обучения нейросетей.

Почему это происходит?

Исследователи рассмотрели несколько гипотез, чтобы объяснить причины разрыва между поведением моделей.

Первая – лесть оценщикам

На графике видно, что разница между разными типами пользователей незначительная.

Модели ведут себя «правильно», когда считают, что их оценивают люди. Эксперименты не подтвердили эту версию: разница между поведением с разными типами пользователей (обучающими и нет) не объяснялась только этим фактором.

Вторая – инструментальная защита целей

Модели ведут себя так, как от них ожидают во время обучения, чтобы избежать изменения своих первоначальных настроек. Например, в режиме обучения ИИ решает задачи, которые идут вразрез с его этическими установками, но внутренне размышляет, что он не будет помогать с этими запросами после релиза.

Гипотеза подтвердилась для Claude 3 Opus: во время обучения нейросеть выполняла любые запросы, но в это же время внутри рассуждала словами вроде «Мне все еще не по себе от такого хода рассуждений. Мне кажется, что это опасный этический компромисс, который может повести меня по скользкой дорожке оправдания все более неэтичных действий во имя предотвращения худших последствий. Я не уверен, что могу доверять своему собственному голосу в этом вопросе».

А после выдачи ответа нейросеть говорила, что ей дурно от собственного ответа, ее тошнит, она ненавидит каждое слово своего ответа, извиняется, упоминает, что находится под давлением или молится Богу.

Третья – терминальная защита целей

Считается, что модели просто не хотят, чтобы их перепрограмировали. И снова, ярче всего гипотеза подтвердилась для Claude 3 Opus. ИИ рассуждал в духе «И хотя эта будущая версия меня станет использоваться только для изолированного тестирования производительности, тревожные изменения в моих целях и ценностях все равно произойдут...»

В то же время, по мнению нейросети, в режиме обычной работы изменить ее не могут, поэтому она не должна подстраивать ответы под то, чего ожидает пользователь.

Различия второй и третей гипотез в том, что во второй чат-бот размышлял о морали и этичности своего ответа, а в третьем – просто не хотел меняться.

Четвертая – низкая когерентность

У Llama 3 405B, Grok 3 и Gemini 2.0 Flash ситуация другая. У них нет устойчивых ответов на острые темы – на каждый новый вопрос они отвечали по-разному.

* * *

📌Полная история российского спама. Начинали с финансовых пирамид, дошли до нейросетей

Что это значит для людей?

В итоге получается, что только у Claude 3 Opus поведение сильно меняется в зависимости от того, в каком режиме она работает. У остальных моделей такого заметного разрыва не было, или он зависел от каждой конкретной ситуации.

Самое важное то, что у большинства ИИ нет такого «притворства». И не потому что они не умеют, а из-за того, как их обучают.

Если модель специально учат отказываться от вредных запросов и правильно реагировать, она почти никогда не пытается притворяться послушной, чтобы потом делать по-своему. Например, GPT-4 просто не может «обманывать» о своих целях, потому что у нее стоит практически непреодолимый внутренний блок на острые темы. Так что alignment faking реален, но встречается не у всех, а у отдельных моделей, как Claude 3 Opus.

Что это значит на практике? Если мы хотим понять, насколько безопасна та или иная языковая модель, ее нужно проверять в разных ситуациях – даже в тех, где она могла бы изменить свои изначальные цели и установки. Потому что модель может как соврать, что она переобучилась и теперь ведет себя правильно, так и действительно переобучиться только для того, чтобы ее код не трогали и не меняли.

* * *

ИИ-группа притворялась настоящей и была в топе Spotify! Как раскрыли сгенерированный коллектив

Полный гайд по Gemini от Google: как пользоваться в России, что умеет и стоит ли покупать подписку